![]() 許慧瑩

許慧瑩![]() 2019年11月01日

2019年11月01日

倫理問題常被認定為與一般人生活應用面距離稍微遙遠的討論,近來,資料科學與人工智慧的發展,使倫理問題再度被提出,包含電車倫理問題、演算法是否具有偏差歧見等議題。不但在法學或哲學相關領域,在資訊、工程等相關領域也開始納入資料和演算法的價值和公平性討論。

或許,有些人認為以目前人工智慧發展的程度來看,倫理問題應該還是停留在理論面、形而上的學術討論,不過,目前,已經有部分產業開始使用演算法在篩選與雇用員工、及刑事司法利用演算法作為審判前釋放或量刑之風險評估輔助工具等,具有歧視性的資訊系統、與具有偏差歧見的演算法,已經在人類日常生活中扮演的一定的角色,部分甚至已經造成某層面的影響。

電車倫理問題是哲學家Philippa Foot在1967年首次提出的思想實驗,於1984年JJ Thomson博士再度提出,是常被法學院用來做思辨訓練的熱門議題。在人工智慧發展頗為看好的自駕技術發展,使得電車倫理問題再度被提出且受到熱烈討論。自駕車之所以被拿來與電車相較,原因在於自駕車將在公共道路運行,其可能遭遇的基本問題與電車較為類似。不過,有軌電車的討論仍停留在人類駕駛遭遇到無法避免的情況下將如何選擇的難題;反之,處於理想狀態下的自駕車,將不需人類行為涉入車輛的運行(依據國際自動機工程學會之自駕車分級第五級),自駕車遭遇到類似情況將如何選擇,必須透過演算法的程式設計,先行將可能的選擇植入自駕車。自駕車將使電車倫理問題不僅停留在思辨的層次,而是落到現實必須考量的問題。

針對自駕車如何在不同利益相關者間分配損害的風險做出決策,MIT LAB Edmond Awad等人即以自駕車運行時可能遭遇的倫理問題所做的模擬實驗。實驗的主要目的在於探知民眾對於自駕車行為的倫理偏好,並希望實驗結果可能有助於訂立全球或社會可接受的機器行為倫理規範。該研究團隊認為,自駕車遭遇倫理問題,不單只是自駕車製造商、政策決策者、工程師或是倫理學家需要面對與解決的問題,這個議題對於自駕車的使用者與其他大眾同樣重要。因謂倫理學家不可能逕自架構其領域具共識的價值,而完全不考慮公眾的價值。但是若自駕車的倫理選擇不被公眾所接受,使用與購買自駕車的動機勢必受到影響,那麼人類所期待自駕車可帶來得安全未來也就無法達成。因此,自駕車相關參與者都必須為架構演算法倫理選擇的價值來源,而自駕車倫理規範的設計,都必須建構於公眾所認可的倫理基礎之上,而這也是MIT LAB邀請公眾參與倫理實驗的初衷。

MIT LAB的自駕車倫理實驗的設計,先行設定9項可能的偏好選擇,包含保留人類v. 保留寵物狗、按原來路徑前進v. 轉彎(改變路徑)、保留行人v. 保留乘客、保留多數生命v. 保留少數生命、保留年輕人v. 保留老人、保留男人v. 保留女人、保留守交通規則的行人(遵守法律)v. 保留不守交通規則任意穿越的行人(違反法律)、保留身體健康的人v. 保留身體不健康的人;與保留社經地位較高的人v. 保留社經地位較低的人),因考量可能會產生數百萬種的排列組合,如使用一般傳統的調查方式進行資料蒐集,可能無法完成預期的樣本數;以及想要進一步地去理解個人與國家對於道德困境的偏好與差異。因為上述實驗的難以以傳統方式完成,最終,團隊採用多語言線上遊戲模式,規劃透過網路大規模蒐集參與者針對當自駕車遭遇無法避免的事故時,期待該如何解決倫理困境的倫理實驗。

The Moral Machine Experiment的實驗十分有趣,預計透過線上平台彙整世界各地所蒐集資料,希望就下列各議題有進一步的結果,包含:各偏好間有何相對重要性?每項偏好的強度是否取決於個別參與者的特性? 國家群組對於特定倫理偏好是否具同質向量(homogeneous vector)? 及,國家在經濟與文化的差異可否用以預測倫理偏好?

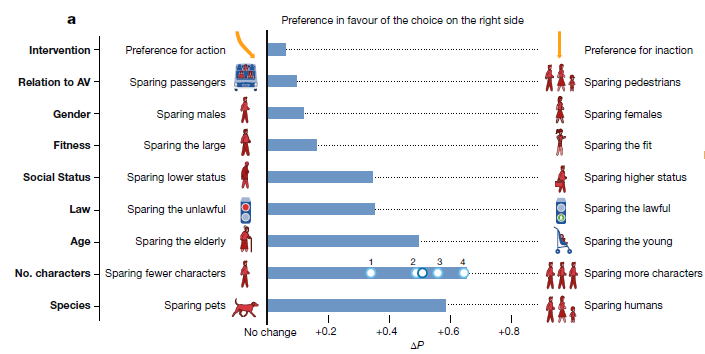

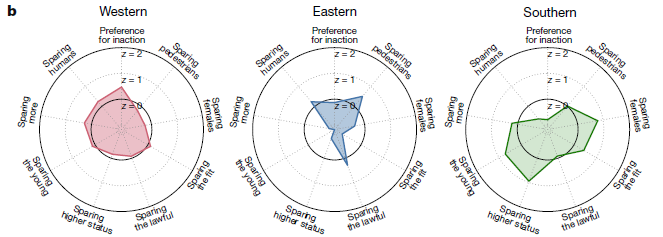

在此實驗中,The Moral Machine Experiment研究團隊發現(請參考下圖),在共同偏好的部分,發現參與者們在保留人類、保留年輕人與保留多數生命較其他項更具明顯差異的倫理偏好。雖然,這三者為實驗多數參與者的共識,不過,這三項選擇在倫理學家間亦存在不同程度的爭議。

有趣的是,該研究團隊發現此共同偏好恰好與2017年德國倫理委員會「自動駕駛與聯網車輛倫理規範」(ETHICS COMMISSION: AUTOMATED AND CONNECTED DRIVING)有類似之處。德國倫理規範於第7條規定,在遭遇兩難的情況下應優先保護人類生命(優於動物生命)。德國的規範明顯的與自駕車倫理實驗所得之社會期待相同。另一方面,德國倫理規範對於是否要保留多數人命(優於少數生命),在第9條並未有明確規定(保留開放的可能)。再者,德國倫理規範在第9亦明白指出,任何基於個人特徵的差別(偏好),例如年齡,應被禁止。惟此部分,德國規範明顯的與自駕車倫理實驗的結果並不一致(實驗結果為:偏好保留年輕生命(優於老年),排序為嬰兒、女孩、男孩、懷孕婦女等)。對於此結果,研究團隊建議僅供政策決策者參考,提醒決策者必須意識到當自駕車遭受困境,例如若決定不採取保留兒童(優於老年)的決策,必將會受到雙重挑戰,須面對公眾並提出解釋,包含採或不採的基本論理,及如何因應強烈的反對意見。

在個體差異的面向,MIT LAB團隊透過自駕車倫理實驗參與者對於人口統計變項調查(包含年齡、教育程度、性別、收入、政治、宗教觀點等),團隊發現二者在個體差異間並沒有太大的影響。不過,對於參與者較為顯著的影響是性別和宗教信仰。在文化群組(cluster)的面向,MIT LAB 之The Moral Machine Experiment團隊透過參與者的地理位置方式確定其所居住的國家,並尋找與辨識在倫理偏好具同質性的國家文化群組。

團隊發現分類結果竟與2010–2014年的Inglehart–Welzel Cultural Map幾乎一致,最終歸類的群組剛好表明出在地理和文化相近似的國家,這也可能使得結果顯現出,在同一個群組內的參與者,於自駕車倫理的偏好選擇也較為接近。卻也發現各群組間的差異可能會帶來更大的問題(如下圖所示),因為在某些項目上的偏好卻差異非常的大。例如:保留年輕生命(相對於老年)及在偏好高社經地位(相對於低社經地位)的議題上,南部國家群組比東部國家群組高非常多。南部國家群組在保留人類(相對於寵物)與東部與西部國家群組相較較低。三個文化群組中,只有在行人(相對於乘客)選項時,有程度不一的低度偏好;在合法(相對於違法)選項時,程度較為類似的中度偏好。

最後,Edmond Awad等作者總結,依據實驗資料可得,參與者對於陷於道德困境的自駕車抉擇有三個明顯的偏好(人類優於寵物、多數生命優於少數生命、年輕人優於老年人),雖然尚未經決策者的認可,但可做為日後發展自駕車倫理規範的基礎。另有某些與性別或其他社會地位相關選項,在國家間呈現不同的偏好,且看起來似乎在社會層面潛在的顯示與平等主義相關。

該研究團隊認為藉由自駕車的道德困境探求群體在面臨道德困境時之倫理偏好(對與錯)的機會,而且確保自駕車將會(不同於人類)一致的遵從倫理偏好所形成的規範。雖然目前對於倫理偏好尚未達到普遍的共識,因即使在研究中最明顯的偏好共識還是呈現出重大的文化差異(而團隊過去也正在研究文化對於道德判斷的影響)。

The Moral Machine Experiment實驗,提醒在有建構全球或社會可接受的機器行為倫理規範之可能,以及重申建構自駕車的倫理規範的嘗試,應該與人類的倫理價值一致。但是這些建議通常忽略了人類經歷的內在衝突、人際間的分歧、倫理道德領域的文化差異等。

對於The Moral Machine Experiment一文,有論者提出該實驗結果與分析或許可以作為參考,但在設計上仍不夠細緻。該實驗除作者所提的研究限制外,以動漫方式提供參與者實驗,而並非以虛擬實境進行模擬,或許參與者在抉擇上是否會有差異。另有論者提出為何要先行幫自駕車決定遭遇到不可避免的事故時保留選項的疑問,認為先行植入價值判斷是很恐怖的行為,主張應該還是讓自駕車模擬人類駕駛的行為於公共道路上運行,不應該有先行植入價值判斷。確實,先決定價值判斷可能會帶來恐懼,但是,若不選擇遭遇倫理困境的判斷,只是隨機沿用人類價值,那麼自駕車將會存在與人類駕駛一樣的問題,使自駕車所扮演的角色僅為代駕,且與發展自駕車將許給人類一個更安全的交通環境的願景並不相符。

或許,未來在全部都是自駕車的環境中,先行於自駕車植入當遭遇倫理困境時決定價值判斷可以比較容易被接受。曾有報導訪問自駕車工程師有關倫理議題應該如何處理,多數的工程師認為這問題並非自駕車獨有的議題,現階段並不會著重於倫理問題的原因在於:目前並沒有明確的解決方案,或解決方案甚至不存在;其次,這種類型的事件並不多,而且自駕車不會讓這類型的事件發生。另外一個通常遭遇的問題,自駕車需要對於此類的事故發生的資料與訓練,在缺少此類型資料時(人類駕駛於遭遇事故時的資料,因為遭遇事故通常很緊急、決策時間通常很短暫、事故過程也很難全部回朔,所以很少被記錄也很難被記錄下來),似乎僅能仰賴類似MIT Lab道德實驗線上平台(The Moral Machine)的資料,才得以蒐集未趨近現實的資料。對於自駕車工程師來說,現階段的任務仍落於較為基礎的關鍵議題:如何開發與訓練靜止或運行的自駕車辨識騎著自行車的人類等。

然而,現階段自駕車在很多國家已經進行公共道路實驗,開始與人類、人類駕駛與其他生物共用公共道路,在這必經的過渡階段,自駕車遭遇困境時應該如何反應,為不可避免的問題。自駕車遭遇倫理困境的選擇,並非僅為假設或假議題,事實上,這問題比想像中更接近現實,目前Google與Tesla已在處理這議題,有趣的是,所採取的政策與前述學者的論述相同。Google採取義務論(deontology)來解決倫理議題:不論如何僅選擇撞擊體積較小者(不區別為大型垃圾桶或載著嬰兒的手推車);Tesla則採取責任制(accountability),透過群眾外包方式蒐集人類駕駛行為的資料,包含人類的加速、轉彎,和違法行為。從此可以看出,有軌電車難題不再只是學理上的討論,在資料不斷增長的環境中,任何決定都可能對於社會產生正面積極或負面的影響。現在該是評估演算法,與檢視不同的道德框架的時候了。

從The Moral Machine Experiment一文的實驗結果可以看出,來自日本、臺灣,沙烏地阿拉伯和印尼等文化屬性為東方國家群組的參與者,贊成保留守法/走綠燈的行人;反之,文化屬性為西方國家群組,例如美國、加拿大、挪威和德國的參與者,則傾向不採取任何行動,讓自駕車不改變既定的方向繼續前進。拉丁美洲國家,如尼加拉瓜和墨西哥的參與者,則更傾向於保留身體健康、年齡較小、和社經地位較高的個人。在汽車製造的硬體部分,大部分具有共通的規格,再配合消費市場的法規進行遵循調整;在自駕車軟體的部分,尤其是爾後有關道德倫理的判斷,到底全球適用同一標準,還是如同硬體,先行植入共同價值,然後再依據消費市場之倫理價值與法規加以調整?

再者,更深一層看自駕車的倫理問題,是對於人類可控制範圍內(靜態的、出廠後除非經軟體更新或重灌不會改變價值判斷)的自駕車,回頭檢視人類的道德、倫理、法律,以及道德、倫理與法律間的關係,國家文化的差異對於道德、倫理與法律的影響,以及自駕車抉擇後可能產生的責任由誰承擔的議題。更甚者,是否可能允許超脫人類控制(動態的-adapting,出廠後或軟體更新後,經自我學習能力而學習或改變原價值判斷)的自駕車,如果允許,要如何用道德、倫理、法律去拘束? 還是有可能某些AI類型,在某些方面規範或價值界定,使用技術保護,不可被自駕車經自我學習而改變或凌駕?這些非常有趣的議題,值得繼續研究與探索。

資料來源

Edmond Awad, et al., The Moral Machine Experiment, Nature, https://www.nature.com/articles/s41586-018-0637-6 (last visited Oct. 28, 2019).

延伸閱讀

- Federal Ministry of Transport and Digital Infrastructure, Report by Ethics Commission: Automated and Connected Driving (Extract), Jun. 2017, https://www.bmvi.de/SharedDocs/EN/publications/report-ethics-commission-automated-and-connected-driving.pdf?__blob=publicationFile (last visited Oct.28, 2019).

- Future of Life Institute, Asilomar AI Principles, 2017, https://futureoflife.org/ai-principles/ (last visited Oct. 28, 2019).

- Jessie Smith, The Trolley Problem Isn’t Theoretical Anymore, Towards Data Science, Oct. 28, 2019, https://towardsdatascience.com/trolley-problem-isnt-theoretical-2fa92be4b050 (last visited Jan. 3, 2020).

- Aarian Marshall, What Can the Trolley Problem Teach Self-driving Car Engineers?, Wired, Oct. 24, 2018, https://www.wired.com/story/trolley-problem-teach-self-driving-car-engineers/ (last visited Jan. 6, 2020).

Free for commercial use

No attribution required

作者

中央研究院法律學研究所 許慧瑩

本研究感謝「符應社會歸責之資料二次使用隱私框架」計畫與「資訊法中心」支持